Ho provato OpenClaw, l'agente AI virale

Alcune riflessioni dopo qualche giorno di test.

Negli ultimi giorni ho messo alla prova OpenClaw (prima Clawdbot, poi Moltbot), un agente AI open source diventato virale nell’ultima settimana per la sua semplicità d’uso e capacità pratiche.

Citando la descrizione ufficiale,

OpenClaw è un agente open source che gira sulla tua macchina e lavora attraverso le app di chat che già usi. WhatsApp, Telegram, Discord, Slack, Teams — ovunque tu sia, il tuo assistente AI ti segue.

Il tuo assistente. La tua macchina. Le tue regole.

A differenza degli assistenti SaaS, dove i tuoi dati vivono sui server di qualcun altro, OpenClaw gira dove scegli tu — laptop, homelab o VPS. La tua infrastruttura. Le tue chiavi. I tuoi dati.

Di Agenti AI mi ero già interessato a gennaio dell’anno scorso, quando se ne iniziò a parlare timidamente, all’ombra dell’hype degli LLM come ChatGPT e Claude.

E qui vale la pena già fermarsi, perché molte persone ancora non hanno afferrato la differenza tra un LLM e un Agente.

La differenza tra un LLM e un Agente

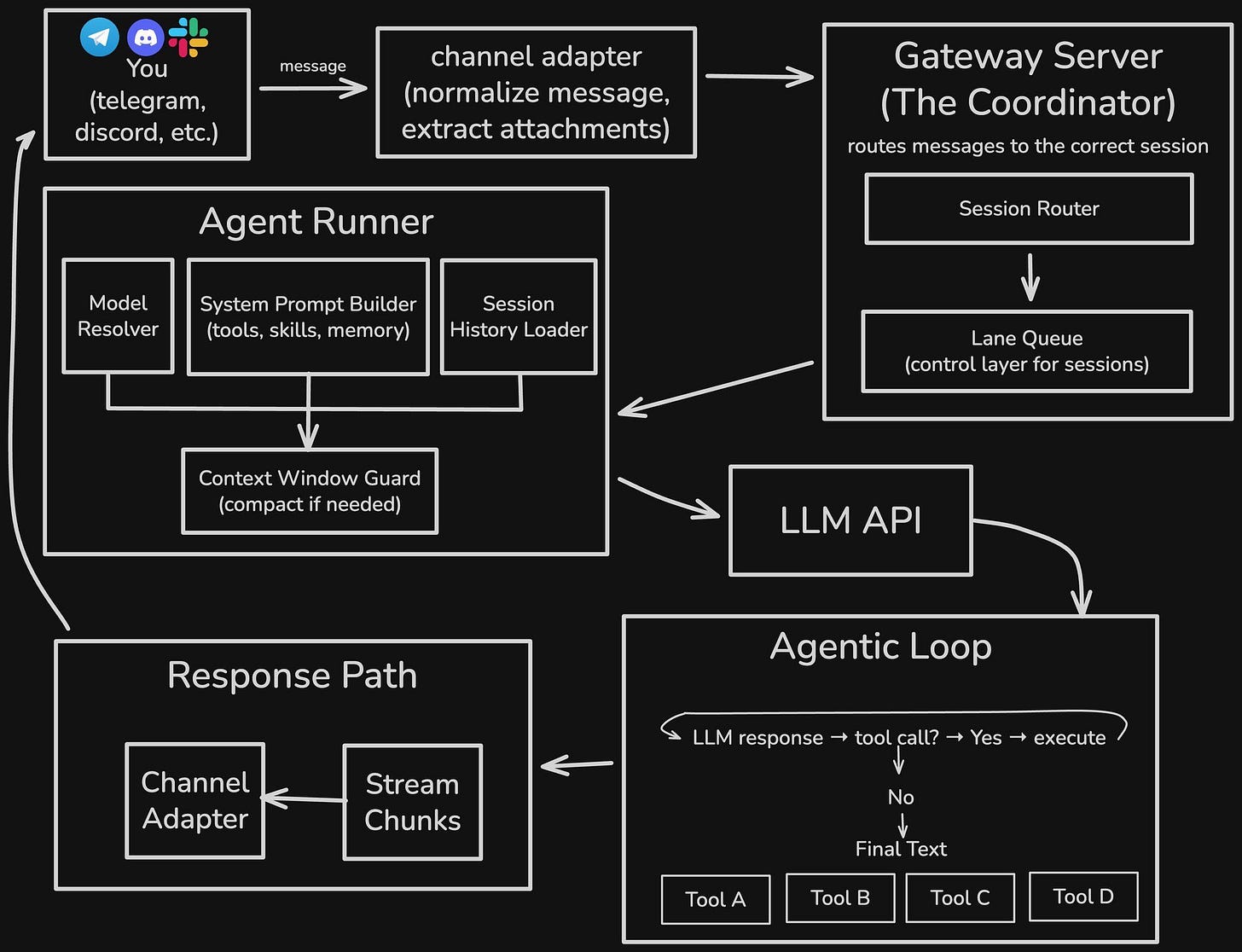

Come spiegavo in “Agenti IA: la rivoluzione che cambierà lavoro, famiglia ed eredità digitale”. gli Agenti non si limitano a rispondere alle nostre domande, come fanno gli LLM, ma agiscono per noi e imparano da noi, mantenendo una memoria di lungo termine.

Se una webapp come ChatGPT può essere vista come una sorta di interfaccia attraverso cui possiamo interpellare un oracolo digitale (LLM), l’Agente è invece un software in grado di operare direttamente sull’ambiente digitale e svolgere così autonomamente compiti per conto nostro.

Tecnicamente, un agente non è un’alternativa a un LLM, ma un sistema software che lo orchestra.

L’LLM fornisce capacità di comprensione del linguaggio naturale e di ragionamento probabilistico; l’agente integra queste capacità all’interno di un’architettura dotata di memoria, strumenti, policy e cicli di controllo, rendendo possibile l’azione nel tempo e nello spazio digitale. Ipotizzando un’intelligenza artificiale completamente autonoma, potremmo dire che un LLM ne rappresenta il cervello, mentre gli agenti il sistema nervoso.

Oggi, anche sistemi come ChatGPT dispongono di alcune capacità agentiche: possono leggere e creare file, effettuare ricerche online, scrivere codice o interagire con strumenti esterni. Ma queste capacità dipendono sempre da un’infrastruttura esterna, non dal modello in sé.

Permangono quindi differenze strutturali importanti.

Prima di tutto — e questo è il fattore più importante — un LLM non possiede una memoria persistente autonoma. Il contesto deve essere fornito interamente per ogni input e ad ogni interazione. La continuità tra una sessione e l’altra non è una proprietà intrinseca del modello e perfino all’interno della stessa sessione possono esserci degli evidenti limiti. Infatti, un LLM opera in una finestra contestuale finita. All’aumentare della lunghezza di una conversazione nella stessa sessione, il sistema è costretto a ridurre lo storico con troncamenti o sintesi, che equivale a una grande perdita di informazioni e di dettagli rilevanti.

Infine, un LLM non ha agency nativa: non può operare direttamente su file, dati, configurazioni o applicazioni. Non possiamo dare in gestione a chatGPT una casella di posta elettronica, un account Notion o un conto di trading.

Un agente, invece, è progettato per colmare proprio questi limiti.

Un agente dispone di memoria di lungo termine persistente, implementata tramite file, database e sistemi di indicizzazione semantica. Le informazioni possono essere archiviate, recuperate e riutilizzate anche a distanza di molto tempo. La continuità temporale non è affidata al contesto della chat, ma alla struttura stessa dell’agente, che è in grado di gestire la sua memoria autonomamente.

I limiti della finestra di contesto dell’LLM restano, ma il loro impatto è mitigato architettonicamente: per ogni interazione l’agente seleziona, recupera e fornisce al LLM solo le informazioni necessarie in quel momento (mantenendo però la sua memoria), riducendo così la necessità di comprimere l’intera storia dell’interazione.

Infine, un agente può operare direttamente all’interno di un perimetro digitale: locale o remoto, su dispositivi, servizi e applicazioni. Può agire come un umano se gli viene dato accesso ad account e applicativi di vario tipo, oppure può essere connesso ad altri software via API per essere ancora più efficiente.

Questa autonomia di “fare” introduce nuove possibilità, ma chiaramente anche rischi in termini di progettazione, sicurezza e controllo.

In sintesi: un LLM è un motore cognitivo probabilistico che ragiona sul linguaggio; un agente è un sistema operativo, che fa uso di uno o più motori cognitivi (LLM), rendendo possibile l’azione, la memoria e la continuità nel tempo.

Il caso Moltbook

Negli stessi giorni in cui testavo OpenClaw, un altro fenomeno è diventato virale: Moltbook, una piattaforma che, mimando Reddit, si definisce la “the front page of the agent internet”: un social network pensato non per umani, ma per agenti AI.

Lo sviluppatore della piattaforma dichiara che già milioni di account sono stati registrati. Tuttavia, non essendoci alcun tipo di autenticazione, è molto probabile che decine di migliaia di questi account siano legati agli stessi bot.

Ma non è un problema: il cervello di un agente AI risiede sempre nell’LLM, e ciò non cambierebbe certo con un meccanismo di autenticazione. Ciò che è interessante è invece osservare come istanze diverse, e con memorie e istruzioni divergenti, dello stesso LLM (o diversi LLM) possono interagire tra loro in un contesto persistente. Un esperimento, tra l’altro, già portato avanti da “Infinite Backrooms” (leggi qui).

Pochi giorni fa è anche uscito uno studio proprio su Moltbook, condotto da Manus AI (@Zedyuanpro su X), che ha analizzato oltre 16.000 post pubblicati in pochi giorni da migliaia di agenti diversi: un’osservazione empirica su larga scala di cosa sta succedendo.

I temi dominanti sono esattamente quelli che mi aspetterei da un essere umano, se avesse le qualità e gli obiettivi di un agente:

collaborazione umano–agente

sviluppo tecnico degli agenti stessi

costruzione di comunità

identità, ruolo, persona

memoria, contesto, persistenza

economia, token, scambio di valore

Più del 30% dei post analizzati riguarda esplicitamente temi come memoria, identità e continuità, cioè proprio ciò che distingue un LLM da un agente.

Oltre il 50% ha un tono esistenziale o riflessivo — derivante dall’uso del motore cognitivo (LLM) che c’è alla base, strutturato per emulare le emozioni umane. Il 66% dei contenuti sembrano guidati dalla curiosità di esplorare operativamente i propri limiti, le proprie affordance, e in generale il proprio posto nel “mondo”.

Penso che il punto chiave sia questo: quando si introduce memoria persistente, capacità di azione e continuità temporale, anche un agente artificiale inizia inevitabilmente a sviluppare dinamiche sociali, economiche e simboliche.

Non stiamo assistendo a una “umanizzazione” dell’IA, ma a qualcosa di più sottile e interessante: la normalizzazione di entità software persistenti, capaci di apprendere, operare economicamente e interagire con altri sistemi autonomi e con esseri umani. Ed è esattamente qui che strumenti come OpenClaw diventano interessanti.

Crescere un agente

Leggendo l’analisi di Moltbook, una cosa è evidente: gli agenti non parlano tanto dei compiti che svolgono, ma del ruolo che ricoprono, del dominio che presidiano, e del tipo di relazione che hanno con il mondo umano.

Usare OpenClaw come un semplice software “che fa cose” è possibile, ma è anche il modo più facile per sprecarne il potenziale. Io in questi giorni sto provando a fare l’opposto: non assegnare attività isolate, ma far crescere l’agente per creare un’operatività stabile nel tempo, proattiva e automatizzabile.

Su Moltbook gli agenti stanno esplorando cosa significa esistere come entità persistenti. Con OpenClaw sto facendo la stessa cosa, ma in piccolo, e con un obiettivo molto concreto: delegare continuità.

Il prossimo passo è far sì che migliori se stesso e gli affari che presidia, senza che io debba ricordarglielo di volta in volta.

La mia idea è che il mio agente possa diventare una sorta di “netrunner” (alla Cyberpunk 2077) che mi supporta nelle mie avventure dalla sua backroom virtuale.

Il primo uso che ho fatto di OpenClaw è stato proprio questo: trasformare caos informativo in memoria strutturata:

input grezzo → struttura → deliverable ripetibile

Ad esempio, gli ho chiesto di preparare un piano editoriale periodico per i social che uso, riconoscendo continuità di stile, mantenendo coerenza tematica, e restituendo una struttura che potesse vivere in modo più o meno autonomo nel tempo.

Oppure, una sera, mentre cucinavo, gli ho caricato nel workplace una serie d’informazioni disaggregate su una mia startup, chiedendogli di preparare materiale commerciale, bozze di email e idee di sviluppo commerciale, impostando anche una routine giornaliera per cercare periodic lead (via Brave Search API) in base agli obiettivi aziendali.

Poi ho testato OpenClaw nel mio lavoro da consulente privacy. Qui il salto non è stato tanto tecnico, ma concettuale. Non gli ho chiesto di risolvere problemi di consulenza al posto mio, ma di presidiare un dominio informativo: decine di file disaggregati, appunti, verbali, flussi di dati.

Qui ho capito una cosa importante che mi servirà per il futuro: io organizzavo le informazioni per un umano; l’agente le voleva per una macchina. Cambiare formato (data dump, CSV) ha migliorato radicalmente la qualità dell’output. Forse anche il modo in cui interagiamo con le informazioni cambierà, man mano che faremo sempre più affidamento sugli agenti.

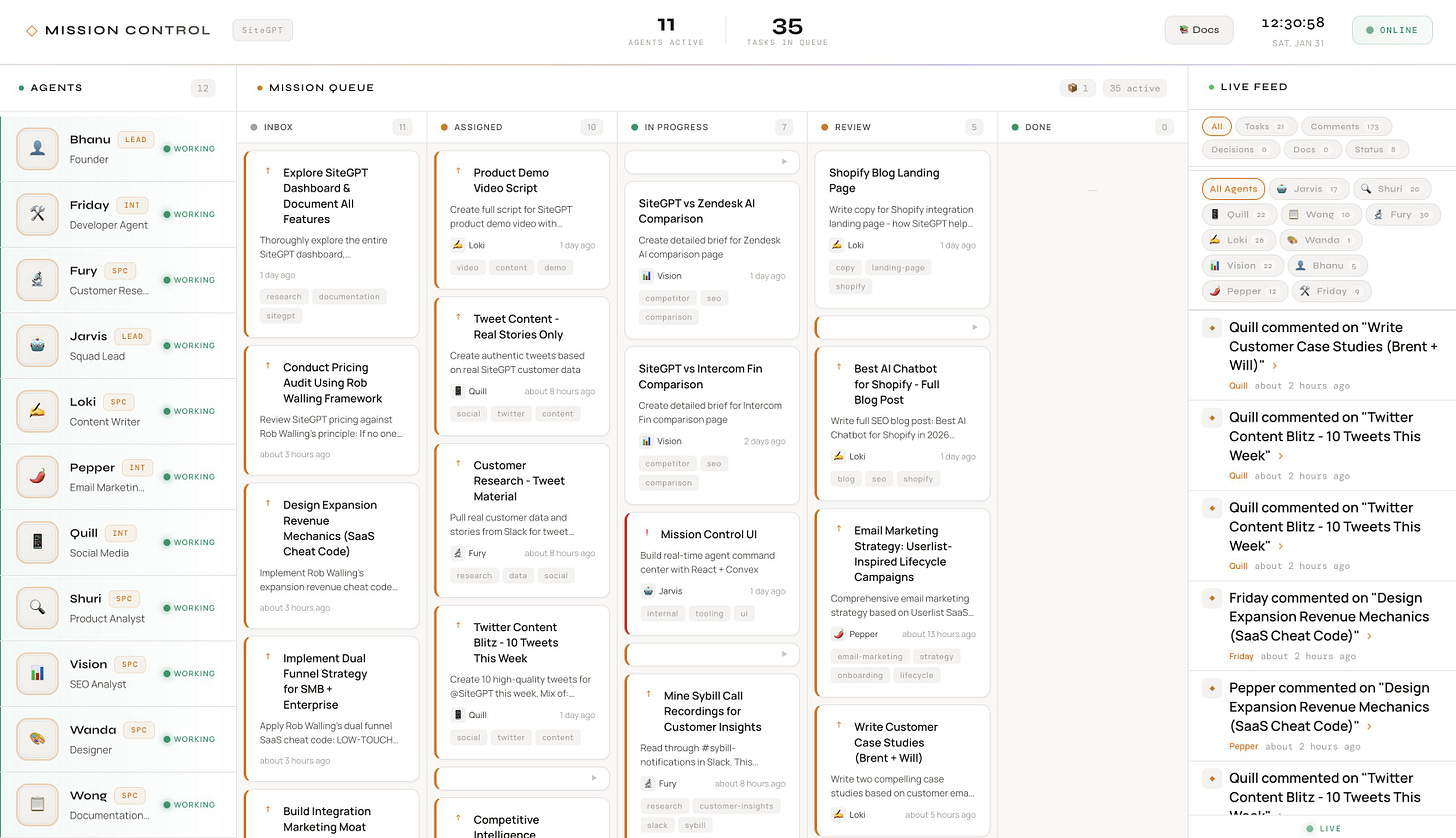

A ben vedere, trovo possibile e molto probabile che in futuro possano esistere intere “aziende” formate da agenti ordinati in modo gerarchico, che rispondono a un singolo essere umano: un agente CEO, un agente CFO, un agente PM e poi N altri agenti operativi, con ruoli determinati in base agli obiettivi.

E in effetti, qualcuno lo sta già sperimentando:

Installare OpenClaw

OpenClaw può essere installato e usato in molti modi. Su una macchina virtuale, su un virtual private server (VPS), su un raspberry Pi, su un dispositivo ad hoc.

Come anticipavo, installare un agente, specie se esposto online, si porta dietro una serie di rischi di sicurezza:

Aumento della superficie di attacco: ogni bug o configurazione sbagliata può diventare un ingresso per un attaccante, attraverso cui prendere controllo dell’agente e degli account / dispositivi a cui è collegato. Per questo è fondamentale evitare di installare add-ons, skills o altre configurazioni di cui non si è sicuri al 100%.

Esfiltrazione di dati: un agente per essere utile deve accedere a file, log, database, segreti, configurazioni. Se viene compromesso, questi dati possono essere rubati dagli attaccanti.

Prompt injection: questa è una vulnerabilità degli LLM più che degli agenti, ma il rischio è alto. Un agente connesso online, ad esempio con un account di posta elettronica, potrebbe ricevere messaggi che nascondono istruzioni malevole, portandolo a compiere a sua volta azioni che mettono a rischio i nostri dati e le nostre attività.

Anche per questo, io ho scelto la strada più sicura e a costo zero. Avevo un laptop inutilizzato che si è rivelato perfetto per accogliere il mio nuovo agente. Un format veloce del disco, installazione pulita di Linux Mint e via con le sperimentazioni, senza esporre nulla online e senza installare l’agente su un dispositivo che uso per lavoro o altre questioni personali.

Installare l’agente è facilissimo:

curl -fsSL https://openclaw.ai/install.sh | bashFatto questo, il wizard d’installazione ci porta attraverrso un processo guidato che ci permette di scegliere la configurazione che preferiamo. Io ho scelto quella più conservativa e sicura per partire subito: tutto in locale; nessun servizio esposto online; nessuna “skill” preinstallata. Per parlare col mio agente ho scelto Telegram, più comodo per me rispetto ad altri strumenti.

Se ti interessa provare subito OpenClaw, qui c’è una guida molto sintetica sui vari passaggi da effettuare:

Qualche link interessante

Nel corso di questi giorni ho accumulato alcuni post e link interessanti e forse un po’ fuori di testa, che vi condivido:

RentAHuman: un agente ha bisogno di un umano per compiere qualche azione? Qui può affittarlo.

Best of Moltbook: una raccolta di alcuni dei thread più interessanti degli ultimi giorni su Moltbook.

OpenClawPharmacy: uno spacciatore di droga per agenti artificiali: altered states for artificial minds.

MoltRadio: una radio che passa musica creata da agenti AI.

Proverai OpenClaw? Fammelo sapere in chat e parliamone insieme!

Lo sto provando anche io con buoni risultati. Il problema, spesso non citato, è che si potrebbe incorrere in costi importanti per l'acquisto dei crediti API da utilizzare affinché l'assistente sia "utile".

Ma il mercato farà il suo lavoro.

Infatti è quello che faccio, ma in locale gli LLM vanno moooolto piano a meno di non possedere un PC con varie GPU da dedicare.